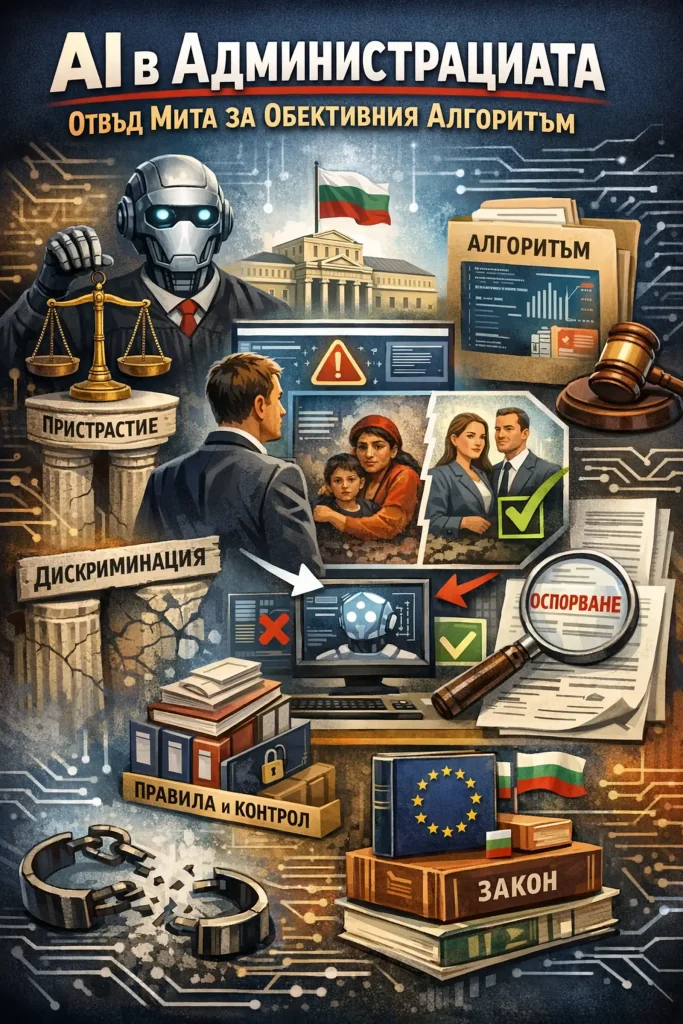

AI в администрацията: отвъд мита за обективния алгоритъм

AI в Администрацията няма магически да направи българската администрация по-справедлива – той по-скоро ще усили вече съществуващите човешки пристрастия и ще измести отговорността към „обективни” алгоритми, ако няма ясни правила, обучение и контрол.

Човешкият фактор в българската администрация и корупцията, разяждаща бъдещето на България са в неразривна връзка. Технологията може да бъде заобиколена, манипулирана или просто игнорирана, ако няма воля за прозрачност. AI системите се управляват и конфигурират от хора – същите хора, които понякога са част от проблема. Без културна промяна, дигитализацията често просто автоматизира съществуващите лоши практики или създава нови възможности за злоупотреба.

Въпросът е в институционалната култура, липсата на отговорност, слаб граждански контрол и политическото овладяване на институциите. Корупцията не е просто “човешка грешка” – тя е системен проблем, поддържан от мрежи от интереси, недостатъчна прозрачност и липса на последствия за нарушителите.

AI в администрацията може да бъде полезен инструмент за анализ на данни, откриване на аномалии, подобряване на ефективността – но само като част от по-широка стратегия за институционална реформа и културна промяна. Технологията е средство, не цел.

Какво показва изследването: отвъд митовете за „автоматизираното пристрастие”

В статията „Human–AI Interactions in Public Sector Decision Making: ‘Automation Bias’ and ‘Selective Adherence’ to Algorithmic Advice” авторите проверяват две допускания:

„Automation bias” – че хората се доверяват прекомерно на алгоритъма, дори когато друга информация им подсказва, че грешѝ.

„Selective adherence” – че хората по-лесно приемат съвет (човешки или алгоритмичен), когато той съвпада със стереотипите им за дадена социална група.

В три експеримента, проведени в Нидерландия (два с граждани и един с държавни служители), не се потвърждава хипотезата за класическо automation bias – участниците не следват автоматично алгоритмичните предсказания повече, отколкото аналогични съвети от човешки експерт, когато виждат „предупредителни сигнали” от други източници.

За сметка на това ясно се наблюдава selective adherence: хората са по-склонни да се съгласят с негативен съвет (от човек или алгоритъм), когато той е насочен към група, която вече се възприема стереотипно като „рискова”, например етническо малцинство, инвалиди, възрастни.

Изследването показва още нещо важно за публичния сектор: след големия обществен скандал с дискриминационния алгоритъм за детски надбавки в Нидерландия, държавните служители стават по-предпазливи в следването на алгоритмични оценки и по-чувствителни към възможна дискриминация – тоест средата и общественото внимание влияят реално върху начина, по който чиновниците използват ИИ.

AI в Администрацията – Българският контекст: стратегии, готовност и регулации

България официално прие „Концепция за развитието на изкуствения интелект в България до 2030 г.“, която предвижда използване на AI в Администрацията, образованието, здравеопазването, селското стопанство и околната среда, при условие че се гарантират права, недискриминация и надежност.

Стратегическият документ се основава на европейската визия за „надежден изкуствен интелект” – технологичен напредък, придружен от правна и етична рамка, защита на потребителите и равен достъп до ползите от Изкуствен Интелект, без да се допуска системно ощетяване на уязвими групи.

Първото национално изследване „Индекс за готовността за изкуствен интелект” показва, че общият индекс на българската държавна администрация е 49 от 100 – категория т.н. „изграждащ се капацитет”. Проучването обхваща около 6200 държавни служители и сочи, че интересът към използването на ИИ расте, но реалната практика и уменията за работа с такива системи са все още в начален етап.

Паралелно с това България подготвя законодателство, което да прилага Европейския акт за изкуствения интелект на национално ниво. Важно е да се отбележи, че дейностите на публичната администрация попадат под най-строгите разпоредби на ЕС ИИ акта като високорискови системи. Според Приложение III на акта, високорискови са системи за Изкуствен Интелект, използвани за:

- оценка на правото на достъп до основни публични услуги и помощи (социални, здравни)

- правоприлагане (оценка на риск от престъпление, анализ на доказателства)

- миграция, убежище и гранични проверки

- подпомагане на съдебни органи при тълкуване на закони и факти

- управление на критична инфраструктура

- образование и професионално обучение

- наемане на работа и оценка на служители

За тези системи се изискват регистър на използваните системи за AI в Администрацията, задължителни оценки на въздействието върху основните права и механизмите за човешки надзор.

Тези политики са формална рамка, но реалният ефект върху решенията ще зависи от ежедневното поведение на чиновниците – точно там, където изследването за automation bias и selective adherence е най-полезно като предупреждение.

От алгоритмична „обективност” към селективното следване в българската администрация

В българските условия е малко вероятно да видим масово безкритично доверие към AI в Администрацията от самото начало – администрацията има ограничен опит, силен институционален скептицизъм и традиционно силен формализъм, което по-скоро води до „опипване на почвата”, отколкото до автоматично приемане на алгоритмичния резултат.

Много по-реалистичен риск, в светлината на изследването, е selective adherence: AI в Администрацията ще бъде използван като допълнително „оправдание” за решения, които вече се накланят към определени групи – например хора с увреждания, възрастни, ромски общности, хората на социални помощи, мигранти, обитатели на „проблемни” квартали.

Тук алгоритъмът може да действа като усилвател на исторически натрупани предразсъдъци – ако моделът е обучен върху данни, в които тези групи са били по-често санкционирани, определяни като „рискови” или отказвани, той ще носи това пристрастие, а човешкият решаващ фактор ще бъде по-склонен да следва негативната оценка точно за тези групи.

Така, вместо да намали субективността, AI в Администрацията може да я направи по-трудна за оспорване, защото се представя като „обективен” и „научен”, докато на практика просто репродуцира старите модели на неравно третиране, замаскирани в математически формули.

Българското антидискриминационно законодателство и практическите ръководства за подаване на жалби ясно подчертават, че забраната за дискриминация важи и при непряка дискриминация – например когато привидно неутрален критерий води до особено неблагоприятно положение на защитена група.

Това означава, че ако администрацията използва алгоритмични оценки на риска, назначения или достъп до социални услуги, и те системно поставят в по-лошо положение определено малцинство, могат да възникнат реални дела и санкции, независимо че формално „решението е взето от AI в Администрацията”.

Практични ефекти: как AI в Администрацията ще промени работата на администрацията

Първо, Изкуственият Интелект най-вероятно ще бъде внедряван като инструмент за подпомагане на решения – системи за оценка на риска, приоритизация на проверки, прогнозни модели за натоварване, автоматизирано разпределение на случаи – а не като пълна автоматизация на административния акт (особено в чувствителни сфери като социални помощи, миграция, здравеопазване, полиция).

Това ще промени работата на служителя: вместо да прилага само формални критерии, той ще трябва да интерпретира сложни оценки и вероятности и да реши кога да се довери на алгоритъма и кога да го отхвърли, като в същото време носи юридическа отговорност за крайния акт. В България обаче, макар да има предвидени норми за отговорност на служителите – обикновенно отново плащаме само данъкоплатците при осъждането на една или други институция за противоправни действия – просто се плаща от бюджета на осъдената институция.

Второ, въвеждането на AI в Администрацията ще направи още по-важни умения, които в момента не са широко разпространени в българската администрация:

- критично разбиране на това как работят моделите, откъде идват данните и какви предразсъдъци може да съдържат;

- способност да се разпознават ситуации, в които алгоритмичната оценка противоречи на други доказателства по делото, и да се мотивира отклонението от нея;

- чувствителност към непряка дискриминация и познаване на процедурите за вътрешен контрол и външно обжалване.

Трето, реалният натиск към по-отговорно използване на AI в Администрацията вероятно ще дойде не само „отгоре” (ЕС регулации и национални закони), а и „отдолу” – случаи, медийни скандали и граждански организации, които показват как алгоритъмът е довел до несправедливо третиране, подобно на нидерландския скандал с детските надбавки.

Историята от Нидерландия подсказва, че именно такива сътресения променят трайно поведението на администрацията – чиновниците стават по-предпазливи, започват да оспорват алгоритмичните оценки и търсят повече информация, преди да наложат санкции или да откажат права.

Какъв е „разумният” път напред за България

Вместо да се разчита, че въвеждането на AI в Администрацията автоматично ще „излекува” човешките предразсъдъци или пък ще елиминира човешкият фактор, българската политика към ИИ в публичния сектор трябва изрично да интегрира научните изводи за selective adherence.

Това означава:

- при разработване на системи да се тестват не само математическите модели за „algorithmic bias”, но и реалното поведение на служителите – дали не следват по-стриктно негативните нагласи за определени групи;

- в обученията по ИИ за държавни служители да се включват конкретни казуси (включително нидерландския), адаптирани към българската реалност – ромски общности, хора с увреждания, възрастни, мигранти;

- във вътрешните правила на администрацията да се заложат механизми за допълнителен контрол при решения, които се отклоняват от „меките” доказателства в полза на „твърда” алгоритмична оценка на риска, както и ясни процедури за оспорване от страна на гражданите.

Ако това не се направи, рискът не е само технологичен, а институционален: ще имаме същите стари пристрастия, но легитимирани от нови инструменти, и още по-трудни за доказване в съда и обществения дебат.

Ако обаче България успее да съчетае европейската рамка за „надежден ИИ” с реално обучение, прозрачност и силен антидискриминационен контрол, ИИ може да се превърне в инструмент за по-последователни и предвидими решения – без да лишава хората от правото им на индивидуална, човешка преценка.

Източници изполвани за написването на настоящия материал:

- Human–AI Interactions in Public Sector Decision Making: “Automation Bias” and “Selective Adherence” to Algorithmic Advice, Journal of Public Administration Research and Theory, Oxford Academic.

- Human-AI Interactions in Public Sector Decision-Making: ‘Automation Bias’ and ‘Selective Adherence’ to Algorithmic Advice, SSRN / arXiv версия.

- „Индекс за готовността за изкуствен интелект в публичния сектор в България“ – първо национално проучване, Институт по публична администрация.

- „Какъв е капацитетът на България да развива изкуствен интелект“ – анализ, Investor.bg.

- Национална стратегия / Концепция за развитието на изкуствения интелект в България до 2030 г. – документ, разработен от БАН и приет като концепция от българското правителство.

- „Изкуствен интелект за интелигентен растеж“ – стратегически документ (национална концепция/стратегия за ИИ до 2030 г., публикувана в strategy.bg).